随着数据中心、下一代数据中心、新一代数据中心等概念的相继提出,数据中心的路虽然越走越远却也走的越来越艰难。数据中心的功率密度与日剧增,高密度数据中心也开始被更多的人所关注。尤其是在这样的盛夏,数据中心高密度问题更是需要处理的难点。

由于机房中设备的密度不同,如果给整个机房盲目降温,会造成机房整体温度不均甚至造成机房过度制冷,不仅浪费了电力资源还增加了额外的支出。所以说机房降温固然重要,但是解决高密度问题也是一大重点。造成数据中心高密度的原因有很多,我们就先从机房内比较重要的一些问题进行分析,再结合看一下不同厂商提出的解决方案都各有什么特点。

高密度数据中心的概念

当前不计成本的高性能计算时代已经一去不复返了,解决尖端问题的高端系统同样也必须降低成本。为了避免由于服务器爆炸性增加而造成机房面积过快扩大以及随之而剧增的各种运行维护费用,机构数据中心要求大幅度缩小服务器(以及存储设备和网络通信设备)的占地面积、提高计算密度、发展高密度计算。

这一方面要求采用新的服务器设计和器件实现更高的计算密度,另一方面要求建设能够支持高密度计算机系统安全稳定运行的数据中心,即高密度计算数据中心。

针对高密度数据中心的设计角度

高密度数据中心虽然与大多数数据中心一样也必须致力于提高能效,但它们在供电和散热两方面都对机房基础设施的容量规划和电源和制冷设施建设提出了更高的要求。从设计角度来分析,建设高密度数据中心必须从如下三方面着手:

1、合理配置机架和空调设备,通过定量计算每个机架的功率密度和热负荷,优化服务器设备在机架中的布局以及机房内机架和空调的布局,为高效供电和散热创造条件;

2、优化供电设施,给每个机架供给足够和适度的电力,满足高密度计算的需要;

3、优化散热制冷系统:把高密度计算元器件在每个机架内部产生的高热量带出机架,避免由于局部高热点而影响设备的稳定运行,甚至损毁部件、造成灾难性的后果;

高密度机房供电系统

高密度计算数据中心中的机架经常是满载的、功率很大,过去一个机架功耗为2-3kW,现在却往往高达20-40kW。早期的机架配电方式已经无法满足高密度设备机架不断增长的电力需求。因此,必须采用创新的机架配电技术来满足为高密度机架供应充足的电力并确保持续稳定运行的要求,包括:

1、支持通过冗余电源实现设备的冗余操作:冗余电源系统需要两个配电电路,分别用于两个电源总线。如果一个总线出现故障,另一路总线仍可处理整个系统的负载。

2、支持高电压和三相电源:传统数据中心利用单相电流工作,其功耗已经不能满足现代高密度计算的需要。因此要求改用三相电源,使用称为高电压交流电源的208伏、三相系统。三相电源通常比单相电源更加高效。此外,与单相电源相比,三相电源更为稳定,更多时间都可处于峰值电压,降低供电损失和发热,不仅能够为满载刀片服务器的机架提供足够功率,而且能够更加稳定持续供电,确保系统的安全稳定运行,从而为支持高密度数据中心供电提供一种通用且经济的电源。

3、使用分段配电技术,能够降低由于过载或维护所引发的意外宕机机率,并减小管理员连续打开多个服务器组而产生的浪涌电流,提高供电的安全性。

4、采用节电配电机柜:通过将数据中心的集中配电改为区域配电方式,将配电管理移到“区域”级,解决了从机箱到机架的集成电源管理问题,并提高供电效率。

5、提供电路监控功能:通过部署可持续监控电流负载的组件,数据中心可以使用少量人力实现高效运行管理。各系统可轻松实现配电电路负载均衡,防止因过载或设备损坏而引发的意外宕机。为了简化管理,用户可以选用模块化PDU管理模块,利用它们来监控数据中心的电源环境。当前市场上已有很多新型配电装置(PDU)可供选择,其中惠普公司新型的模块化PDU在每个机架上集成了插座、电缆与断路器,提供一系列领先的特性支持高密度机架稳定安全稳定运行和节电。

高密度机房制冷转变

在以往的空调系统设计中,多采取集中制冷模式,将空调房间考虑成一个均匀空间,按现场最大需求量来考虑。这种模式忽视了空间各部分的需要,缺少考虑制冷效率、制冷成本的意识。目前随着科学技术的发展以及高密度大型数据中心的建设需求,人们逐渐认识到按需制冷的必要和集中制冷的弊端。据了解,目前国内数据中心常用的方式主要为风冷精密空调系统。由于建筑空间的限制,常常没有足够的空间放置室外冷凝器,冷凝器排列过于紧密,造成散热效果差,空调系统效率较低,难以解决高密度制冷问题。而目前水冷制冷方式可以在机柜内冷却服务器等设备排出的热空气,加快了制冷循环过程,进而提高制冷效率。

带有FreeCooling功能的冷冻水精密空调系统虽然在一次性投入上比风冷精密空调系统高出13%,但在制冷效率上则高出了54%。从长期运行的费用来看,FreeCooling功能的冷冻水精密空调系统比风冷精密空调系统每天节电38094度。在西安地区一个冬季就可收回FreeCooling部分增加的投资,如是在寒冷的内蒙或东北地区,不到半个冬季就可收回FreeCooling部分增加的投资。

高密度机房机架配置

机架是数据中心机房内安装各种设备(服务器、存储和网络设备等)的重要组件,也是整个散热基础设施的重要组成部分。例如,各种服务器、存储与网络设备的机箱就是插入在机架中,通过各种线缆联接成为高密度计算系统。因此,解决好机架的供电和内部的散热等问题是提高高密度计算系统散热效率的关键。

为此,首先要合理配置机架内部设备。随着服务器功耗的提高,传统的数据中心往往不得不把机架大多数容量空置、来避免供电不足和过度发热,这显然不利于高密度数据中心的建设。反之,如果机架过满又很可能会超出机房供电和散热的能力。

因此,必须从定量计算机架功率密度和热负荷出发、合理配置机架内部设备,从而充分利用机房供电和散热的能力,奠定建设高密度数据中心的基础。至于,如何计算在一个标准机架中可以容纳多少台这样的服务器和估算一个机架内服务器的功耗会更加困难。

因为计算功耗需要参考多个变量(如每个机架内的服务器数量、每台服务器组件的类型和数量等)。对于机架而言,一个非常有用的标准是功率密度,即每机架单位的功耗(瓦/单位)。功率密度包含了机架密度所涉及的所有变量。实际上,计算机所消耗的电源几乎全部都转变成了热量。计算机所产生的热量一般以英国热量单位BTU/小时来表示,1瓦等于3.413BTU/小时。

因此,可以按照下式来计算出机架热负荷:热负荷=功率[瓦]x3.413BTU/小时/瓦。例如,一台惠普公司制造的DL360G4服务器的热负荷为:460瓦x3.413BTU/小时/瓦=1,570BTU/小时。一个42U机架容纳DL360G4服务器的热负荷将近65,939BTU/小时。数据中心的配置主要环绕功耗和热负荷与机房供电和散热能力的配合。

IT设备厂商一般会在其产品规格中提供功率和热负荷信息,在设计高密度数据中心时,必须根据厂商提供的数据估算每机架的功率和热负荷,进行数据中心机房规划。

规划中,需配置足够的电源、并留有足够的余量,既要避免因配置容量不足而影响设备正常运行,又要避免因留有余量过大而导致能效降低。在设计和建设高密度计算数据中心时必须评估各种设备的电源需求与热负荷,进行合理的机架配置。

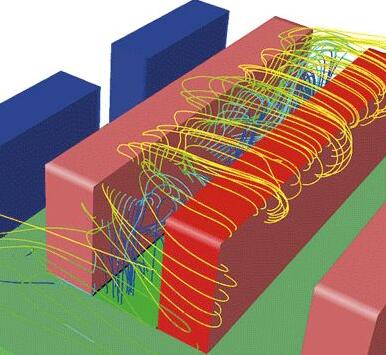

比较好的方法是静态智能散热技术,通过使用流体动力学模型进行模拟、根据已明确的数据中心设备的热负荷,来确定冷却资源的最佳布局和供应量。它可以将每一个空调设备的散热负荷与其额定功率进行比较,以判断空调设备是否得到了高效的利用或过分“供应”。

高密度数据中心气流管理

随着服务器计算能力的提高,以及数据中心的新建或现有的数据中心升级,改善空气调节方法现在也是强制性的。问题不在于不能提供足够的空气调节系统,而是空调必须提高到需要的地方。这意味着提供冷却的流动特性的气流,必须认真研究机房空调通过设备的机架,并返回到机房空调的过程。

数据中心需要安排好热通道/冷通道,冷通道间距为7块标准地板。为实现更好的气流组织,也可以对冷通道或热通道做完全的封闭。热通道要避开建筑横梁的影响,冷通道可设在建筑横梁的正下方。为进一步提高主机房的热交换效率,推荐调整主机房的干球温度和湿度。推荐环境温度为18-27℃,湿度为5.5℃的露点-69%相对湿度或15℃的露点。在推荐范围内,设定的冷通道环境温度越高,空调交换效率就越高,越节能。

高密度机房布线问题

高密度的数据中心中,传统的主干和水平链路配置(如常见的每个EDA机柜接入24根双绞线或24芯光纤)已经不能适应刀片式服务器及SAN存储设备的需求,而由端口数量增加引起的机柜安装单元的占用又与昂贵的数据中心单位面积成本形成极大的矛盾。

面对挑战,大量新的布线技术应运而生,如采用屏蔽铜缆系统提高线缆和连接硬件的安装密度,采用刀片式跳线杜绝高密度环境跳接插拔误操作的可能性,采用光纤预端接系统简化线缆布放和端口连接,采用角型配线架减少水平理线架的数量,采用机柜间垂直空间安装跳接端口等。

但是6A系统因需考虑外来串扰的影响,线缆外径和端口间距均较以前的布线类别有所增加,无法顺应高密度数据中心的发展趋势。而Z-MAX6A铜缆系统采用创新的推拉式RJ45设计,使跳线可以更快的移动、增加和变更,特别适合48端口的机架式交换机和插卡式交换模块。配合另一个专利的LockITTM技术,还可以给每个BladePatch刀片式快接跳线的插头端增加一个安全锁,防止了未经授权的端口访问,提高了数据中心的安全性和可靠性。

光纤应用是数据中心的另一个热点,基于FC的存储区域网络需要大量的光纤连接,而新型的SAN导向器又把接口密度提升到1U96芯,下一代的40G/s和100G/s网络更是直接需要8芯/20芯光纤的支持。传统的光缆熔接技术不再适应高密度大批量的光纤安装,新的MTP/MPO预端接技术以其优异的性能和快速的实施方式获得了数据中心用户的青睐,成为高密度数据中心光纤连接的技术。